【PostgreSQL】26万件のデータから120件の抽出に100ミリ秒

関連記事

- 【#PostgreSQL】3ヶ月ぶりぐらいにSQLを眺めているが,判らん!!モルモルモル 【2024年07月25日(木)】

- 【#PostgreSQL】太古の昔から動いているシステムのレコード,手修正作業をするなど,と 【2023年10月06日(金)】

- 【#PostgreSQL】テーブルから取得したレコードセットをCSVへ落とそうとすると,空ファイルが出来る...ドロドロドロ 【2023年03月08日(水)】

- 仕事オワタ 昼寝しよ(GRB爆 【2023年02月23日(木)】

- 【#PostgreSQL】鬼のような4本のSQLを書き上げた 【2023年01月13日(金)】

ほど,かかっていたんであ~だこ~だいじってみた

これ最終的には1000件/26万件ぐらいになりそうなんで500ミリ秒とか行きそうな予感だったもんで?

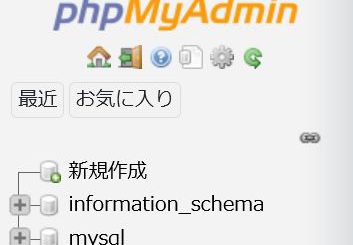

SQLの構文解析アナライザ通してみたら

group byな節(max()でグルーピングしてるのよ)があって,そこが26万件のシーケンシャルサーチ掛かっている

select max(id) as maxdatid , マスタ1の主キー, マスタ2の主キー from データテーブル where (activefl = true) group by マスタ1の主キー, マスタ2の主キー26万件の中からマスタ1の主キー, マスタ2の主キーでグルーピングして,最新のレコードのみ(今はマスタの登録件数少なくて120件)抽出なクエリ

100行超えのSQLの中の中核部分じゃげな

してこれ,インデックスからひっぱれんのか

あ~だこ~だやったけど

結局,納品中のクエリが一番速いってのがわかった(GRB爆

つまり,今んところ100ミリ秒より速く出来ねぇ~

う~む,現場は耐えられるのかねぇ...

神の味噌汁状態じゃが(微汗

コメント

【#花粉症】目が腫れてキターくしゃみも止まらん.いよいよ花粉もピークか?

【#衆議院選挙2026 】自民 316議席獲得 単独で3分の2超 中道は49議席

【#衆議院選挙2026 】自民単独で過半数大きく上回り300議席に達する可能性

【BW55T】UPSが死んだ...ドロドロドロ😭これは人類滅亡間違いなし!なので発注(爆

広島カープの羽月隆太郎容疑者、「ゾンビたばこ」使用の疑いで逮捕

【#総選挙】衆議院選挙 きょう公示 12日間の選挙戦へ

青森 スノーモービル乗るため入山の約10人と連絡取れず 遭難か

【#不発弾】宮崎市中心部の不発弾 17日に処理 避難指示や交通規制予定(26/1/17)